Weltweit steigt der Einsatz schulischer Leistungsüberprüfungen. Anhand von internationalen Schülertests der vergangenen 15 Jahre zeigt dieser Beitrag, dass die Einführung extern vergleichender Prüfungen die Schülerleistungen in Mathematik, Naturwissenschaften und Lesen verbessert, nicht hingegen die Einführung von internen Tests oder Inspektionen der Lehrkräfte ohne externen Vergleich. In vielen Ländern haben regelmäßige Leistungsüberprüfungen von SchülerInnen in den letzten Jahren zugenommen. Beispielsweise berichtet die Exekutivagentur Bildung, Audiovisuelles und Kultur der Europäischen Kommission, dass 8 der 18 von ihr untersuchten Länder zwischen 2000 und 2015 nationale Tests eingeführt haben, die am Ende der Grundschule oder Sekundarstufe I über die weitere Schullaufbahn der

Topics:

Annika B. Bergbauer, Eric Hanushek, Ludger Wößmann considers the following as important:

This could be interesting, too:

finews.ch writes DC Bank startet beschwingt ins Jubiläumsjahr

finews.ch writes Vom roten Teppich auf die Bahnhofstrasse

finews.ch writes SNB lockert Geldpolitik auch mit dem Argument der Asymmetrie

finews.ch writes Schweizer Banken-Marken verlieren international an Boden

Weltweit steigt der Einsatz schulischer Leistungsüberprüfungen. Anhand von internationalen Schülertests der vergangenen 15 Jahre zeigt dieser Beitrag, dass die Einführung extern vergleichender Prüfungen die Schülerleistungen in Mathematik, Naturwissenschaften und Lesen verbessert, nicht hingegen die Einführung von internen Tests oder Inspektionen der Lehrkräfte ohne externen Vergleich.

In vielen Ländern haben regelmäßige Leistungsüberprüfungen von SchülerInnen in den letzten Jahren zugenommen. Beispielsweise berichtet die Exekutivagentur Bildung, Audiovisuelles und Kultur der Europäischen Kommission, dass 8 der 18 von ihr untersuchten Länder zwischen 2000 und 2015 nationale Tests eingeführt haben, die am Ende der Grundschule oder Sekundarstufe I über die weitere Schullaufbahn der SchülerInnen entscheiden (Eurydice 2009, 2017). Im gleichen Zeitraum ist in 23 der 59 Länder, die wir in unserer Analyse betrachten, der Anteil der Schulen, die standardisierte Prüfungen für externe Vergleiche einsetzen, um mehr als 20 Prozentpunkte gestiegen.

Über den Anstieg der Schülertests und die Art ihrer Verwendung im Schulbetrieb wird weltweit viel diskutiert. Einerseits vertreten Befürworter die Meinung, dass der zunehmende Einsatz von Tests und Prüfungssystemen zur Verbesserung des Bildungserfolges notwendig sei. Sie argumentieren, dass die Beurteilung von SchülerInnen und Schulen und deren Leistungsvergleich Anreize für bessere Ergebnisse schaffe. Beispielsweise plädiert die Weltbank in ihrem aktuellen Weltentwicklungsbericht zum Thema Bildung explizit für eine Ausweitung von Leistungsüberprüfungen und kommt zu dem Schluss, dass es zu wenig Messung von Lernergebnissen gibt, nicht zu viel (World Bank 2018, S. 17). Andererseits sehen Kritiker Leistungstests mit Konsequenzen als unangemessen an (Koretz 2017) und argumentieren, dass ihr vermehrter Einsatz der Bildung schade (Hout und Elliott 2011).[ 1 ] Bei übermäßigem Einsatz von Leistungsüberprüfungen klagen einige Lehrkräfte, Eltern und SchülerInnen gerne über "Testeritis".

Unterschiedliche Formen der Leistungsüberprüfung

Aus unserer Sicht vernachlässigt diese Debatte oftmals die wichtige Unterscheidung zwischen verschiedenen Formen und Verwendungen der Tests. So ist beispielsweise die Diskussion von Leistungsüberprüfungen in den USA weitgehend auf Rechenschaftssysteme von Schulen beschränkt, wie sie im No Child Left Behind (NCLB) Gesetz angelegt sind. Solche auf eine große Schülerschaft normierte Tests, deren externer Vergleich Konsequenzen für die Schulen hat, unterscheiden sich grundlegend von Tests, die von den Lehrern selbst erstellt wurden, um die Lernfortschritte ihrer Schulklasse zu überprüfen. Auch ist eine Beurteilung von Lehrkräften auf Basis der Leistungen ihrer SchülerInnen etwas anderes als die Auswahl von SchülerInnen für den Zugang zur Universität.[ 2 ] In der Realität gibt es folglich viele verschiedene Formen von Leistungsüberprüfungen. Um die Auswirkungen von Prüfungssystemen zu verstehen, müssen deshalb ihre jeweilige Verwendung und die dadurch entstehenden Anreize genau berücksichtigt werden.

Unterschiedliche Ausprägungen der Testverwendung können zu leistungsfördernden Anreizen unterschiedlicher Stärke für unterschiedliche Akteure in unterschiedlichen Umfeldern führen. Wie Leistungsüberprüfungen das Lernen der SchülerInnen beeinflussen, wird also davon abhängen, wie sich die durch die Tests entstandene Information in Anreize und Verhaltensweisen der Akteure umsetzt.

Deshalb ist es unklar, inwieweit sich Erkenntnisse bestehender Analysen der Effekte von Prüfungssystemen, die sich größtenteils auf die USA beziehen (siehe Figlio und Loeb 2011 für einen Überblick), verallgemeinern lassen. Politikmaßnahmen wirken im jeweils spezifischen institutionellen Rahmen nationaler Schulsysteme; insofern vernachlässigen die Studien allgemeine Bedingungen, die das ganze Land betreffen. Außerdem werden Prüfungssysteme oft auf nationaler Ebene eingeführt, was die Bildung adäquater Vergleichsgruppen zur Evaluierung der Ergebnisse der Reformen erschwert. Folglich wurden die meisten Anwendungen ausgeweiteter Leistungsüberprüfungen bisher nicht angemessen evaluiert.

Ausnutzung von Veränderungen internationaler Schülertests über die Zeit

In einer neuen Studie (Bergbauer, Hanushek und Wößmann 2018) verwenden wir internationale Vergleiche, um den Einfluss verschiedener Formen und Anwendungen von Leistungsüberprüfungen auf das Leistungsniveau der SchülerInnen zu untersuchen. Unsere Analyse trägt zu der wachsenden Literatur bei, die die Determinanten von Schülerleistungen mit länderübergreifenden Daten erforscht (vgl. Hanushek und Wößmann 2011; Wößmann 2016). Die international vergleichende Analyse ermöglicht es zu betrachten, wie generelle institutionelle Strukturen mit den jeweiligen Besonderheiten von Leistungsüberprüfungen und schulischen Rechenschaftssystemen interagieren. Dieser länderübergreifende Ansatz erlaubt uns zu untersuchen, welche Aspekte von Prüfungssystemen sich auf weite Anwendungsfälle verallgemeinern lassen und welche nicht. Natürlich stehen diesen Vorteilen auch Kosten gegenüber, denn die Untersuchung des Einflusses verschiedener schulpolitischer Maßnahmen im Ländervergleich bringt ihre eigenen Herausforderungen mit sich.

Unsere empirische Analyse nutzt die zunehmend reicheren internationalen Schülerleistungsdaten. Der PISA-Test (Programme for International Student Assessment), in dem die Organisation für wirtschaftliche Zusammenarbeit und Entwicklung (OECD) die Mathematik-, Naturwissenschafts- und Leseleistungen repräsentativer Stichproben von 15-jährigen SchülerInnen testet, bietet eine regelmäßig wiederkehrende Beobachtung der Schülerleistungen in vielen Ländern. Konkret kombinieren wir die Mikrodaten von über zwei Millionen SchülerInnen in 59 Ländern aus sechs PISA-Wellen in den Jahren 2000 bis 2015.

Die PISA-Studie umfasst nicht nur Leistungsmessungen, sondern auch umfangreiche Hintergrundinformationen zu den SchülerInnen und Schulen in den teilnehmenden Ländern. Aus diesen Befragungsdaten und weiteren internationalen Datenquellen haben wir eine Reihe von Maßen unterschiedlicher Formen von Leistungsüberprüfungen erstellt. Wir kombinieren 13 einzelne Indikatoren, die auf der Ebene von Ländern und Wellen beobachtet werden, in vier Kategorien der Testverwendung, die unterschiedliche Anreizmuster widerspiegeln: extern vergleichende Prüfungen, standardisierte Tests ohne externen Vergleich, interne Tests sowie interne Beurteilung der Lehrkräfte.

Diese Datenbasis ermöglicht Panelanalysen auf Länderebene, die auf Veränderungen in den Prüfungssystemen innerhalb der Länder über die Zeit beruht. Da im Beobachtungszeitraum viele Länder ihre Prüfungspraktiken reformiert haben, können wir die Politikmaßnahmen mit Testergebnissen in Panelmodellen verknüpfen, die fixe Effekte für jedes Land und jedes Jahr berücksichtigen. Die Schätzungen ignorieren also sämtliche Niveauunterschiede zwischen den Ländern und nutzen ausschließlich Veränderungen in den Prüfungsregimen, die innerhalb der Länder über die Zeit zu beobachten sind.

Aufbauend auf früheren Analysen der Effekte von Schulautonomie (Hanushek, Link und Wößmann 2013) nutzen wir die Individualdaten der SchülerInnen für Schätzungen auf der Mikroebene, während wir die Maße der Prüfungspraktiken in jedem Jahr auf der Länderebene aggregieren, um Verzerrungen durch eine mögliche Selektion von SchülerInnen in bestimmte Schulen innerhalb eines Landes zu vermeiden. Die Verwendung fixer Effekte für jedes Land und Jahr erlaubt es uns, unbeobachtete zeitinviariate Ländermerkmale sowie gemeinsame zeitspezifische Schocks zu berücksichtigen. Darüber hinaus beinhalten unsere Modelle eine Reihe beobachteter Einflussfaktoren auf Ebene der SchülerInnen, Schulen und Länder. Die wichtigste identifizierende Annahme unseres Ansatzes besteht in der Standardannahme von Panelmodellen mit fixen Effekten: Ohne Reform würde die Veränderung der Schülerleistungen (nach Berücksichtigung der Kontrollvariablen) in Ländern, die Prüfungen eingeführt haben, der Veränderung der Schülerleistungen in den Ländern ähneln, die ihre Prüfungssysteme nicht verändert haben.

Externe Vergleiche sind entscheidend, damit Tests die Schülerleistungen verbessern

Unsere Ergebnisse zeigen, dass einige Formen der Leistungsüberprüfung das Lernen der SchülerInnen beeinflussen, während andere keinen erkennbaren Einfluss haben. Insbesondere verbessert eine Ausweitung von extern vergleichenden Prüfungen die Schülerleistungen, nicht jedoch eine Ausweitung interner Tests.

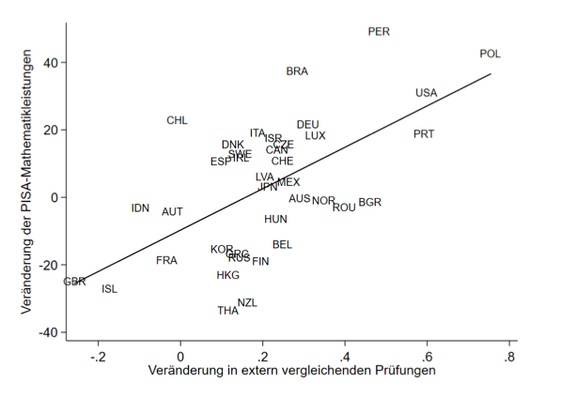

Am einfachsten lassen sich unsere Ergebnisse durch einen Vergleich der langfristigen Veränderungen in der Verwendung externer Prüfungen und in den Schülerleistungen der Länder zwischen 2000 und 2015 veranschaulichen. Wie die folgende Abbildung zeigt, haben sich die durchschnittlichen Mathematikleistungen der SchülerInnen in Ländern, die die Verwendung extern vergleichender Prüfungen ausgeweitet haben, über den 15-Jahres-Zeitraum systematisch verbessert im Vergleich zu Ländern, die die Verwendung dieser Form von Prüfungen nicht ausgeweitet oder sogar verringert haben. Im Gegensatz dazu gehen Veränderungen in der Verwendung von internen Tests nicht systematisch mit Veränderungen der Schülerleistungen der Länder einher.

Abbildung 1: Länder, die zwischen 2000 und 2015 extern vergleichende Prüfungen ausgeweitet haben, haben ihre Schülerleistungen verbessert

Anmerkungen: Zusammenhang zwischen der Veränderung der durchschnittlichen PISA-Mathematikleistung eines Landes von 2000 bis 2015 und der Veränderung in extern vergleichenden Prüfungen nach Herausrechnung zahlreicher Einflussfaktoren auf Ebene der SchülerInnen, Schulen und Länder. Quelle: Eigene Darstellung auf Basis von Bergbauer, Hanushek und Wößmann (2018), Tabelle 7, Spalte 3.

Diese Ergebnisse finden sich ebenso in unseren detaillierten Regressionsanalysen auf Individualebene, die die vollständige Variation in den Testpraktiken und Schülerleistungen im Panel der sechs PISA-Wellen nutzen. Einerseits bestätigen die Regressionsergebnisse, dass eine vermehrte Verwendung extern vergleichender Prüfungen mit höheren Schülerleistungen in den internationalen Tests einhergeht. Dies zeigt sich für Schülerleistungen in allen drei Fächern – Mathematik, Naturwissenschaften und Lesen. Darüber hinaus trifft es für schulbasierte Formen extern vergleichender Prüfungen, die die Leistungen der Schulen mit den jeweiligen regionalen oder nationalen Leistungen vergleichen, ebenso zu wie für schülerbasierte Formen extern vergleichender Prüfungen wie national standardisierte Prüfungen, die über den weiteren Bildungsweg entscheiden.

Andererseits ergeben sich für interne Tests, die nur informieren oder Fortschritte überwachen ohne externe Vergleiche zu ermöglichen, kaum erkennbare Effekte auf die Schülerleistungen. Gleiches gilt für interne Prüfungen, die zur Beurteilung der Lehrkräfte eingesetzt werden, einschließlich Inspektionen von Unterrichtsstunden.

Auch die Einführung von standardisierten Tests ohne externe Vergleiche geht im Durchschnitt nicht systematisch mit Veränderungen in den Schülerleistungen einher. Allerdings hat sie in ursprünglich schwach abschneidenden Ländern positive Effekte, nicht hingegen in Ländern mit bereits starken Leistungen. Ein ähnliches Muster, dass sich stärkere Effekte in leistungsschwächeren Schulsystemen finden, zeigt sich auch für die bereits angesprochenen Effekte schulbasierter Formen extern vergleichender Prüfungen.

Eine interessante Placebo-Analyse zeigt, dass sich die Schülerleistungen in dem Jahr, in dem extern vergleichende Prüfungen tatsächlich eingeführt werden, verbessern, nicht jedoch in der vorherigen Welle, in der die Prüfungen noch nicht eingeführt worden sind. Dies zeigt auch, dass das vorherige Leistungsniveau eines Landes nicht vorhersagt, ob das Land in Zukunft Prüfungen einführen wird, was gegen die Möglichkeit spricht, dass eine endogene Einführung der Prüfungssysteme in Bezug auf frühere Leistungen ein relevantes Bedenken bei der Interpretation unserer Ergebnisse ist. Weitere Robustheitsanalysen bestätigen, dass die Ergebnisse nicht von einzelnen Ländern oder von Veränderungen im PISA-Testverfahren abhängen und dass sie robust sind in Untergruppen von Ländern und bei Berücksichtigung von Ausschlussraten aus den PISA-Tests.

Schlussfolgerungen

Aus politischer Sicht wird es zunehmend wichtiger, die Auswirkungen verschiedener Prüfungssysteme zu verstehen. Mit den sich verändernden Prüfungstechnologien wird es immer leichter, Leistungserhebungen durchzuführen. Darüber hinaus hat die Verknüpfung von schulischen Rechenschaftssystemen mit Reform- und Verbesserungsvorhaben zu einer weltweiten Zunahme von Tests zu Rechenschaftszwecken geführt. Gleichzeitig haben Gegenreaktionen gegen verschiedene Verwendungsformen von Tests und Leistungsüberprüfungen die Prüfungspraktiken in eine oftmals kontroverse öffentliche Debatte geführt. Unsere Analysen können diese Debatte mit wissenschaftlicher Evidenz informieren.

Unsere Ergebnisse zeigen, dass Prüfungssysteme, die standardisierte Tests zum Vergleich der Ergebnisse mit anderen Schulen und SchülerInnen verwenden, die Schülerleistungen verbessern. Diese Prüfungssysteme haben üblicherweise Konsequenzen für die Beteiligten und erzielen bessere Ergebnisse als Systeme, die standardisierte Tests ohne externe Vergleiche verwenden. Sie erzielen auch bessere Leistungen als Systeme, die sich auf lokale oder subjektive Informationen verlassen, die nicht direkt zwischen den Schulen oder Klassen verglichen werden können. Für solche internen Tests konnten kaum Effekte auf die Schülerleistungen festgestellt werden.

Darüber hinaus sind die Effekte der Einführung von Prüfungssystemen tendenziell stärker in solchen Schulsystemen, die bisher schwache Schülerleistungen aufweisen. Dieser ungleiche Einfluss von Prüfungssystemen in Ländern mit unterschiedlichen Leistungsniveaus zeigt die Gefahren einer allzu breiten Verallgemeinerung der Befunde von spezifischen Prüfungssystemen einzelner Länder auf.

Andrews, Paul, mit Koautoren. 2014. "OECD and Pisa tests are damaging education worldwide.[ a ]" The Guardian (accessed June 20, 2018).

Bergbauer, Annika B., Eric A. Hanushek, Ludger Wößmann. 2018. "Testing." NBER Working Paper 24836. Cambridge, MA: National Bureau of Economic Research.

Eurydice. 2009. National testing of pupils in Europe: Objectives, organisation and use of results. Brussels: European Commission; Education, Audiovisual and Culture Executive Agency (EACEA), Eurydice.

Eurydice. 2017. Online platform, ec.europa.eu/eurydice. Brussels: Education Audiovisual & Culture Executive Agency (EACEA), Eurydice Unit.

Figlio, David, Susanna Loeb. 2011. "School accountability." In Handbook of the Economics of Education, Vol. 3, edited by Eric A. Hanushek, Stephen Machin, Ludger Wößmann. Amsterdam: North Holland: 383-421.

Hanushek, Eric A., Susanne Link, Ludger Wößmann. 2013. "Does school autonomy make sense everywhere? Panel estimates from PISA." Journal of Development Economics 104: 212-232.

Hanushek, Eric A., Ludger Wößmann. 2011. "The economics of international differences in educational achievement." In Handbook of the Economics of Education, Vol. 3, edited by Eric A. Hanushek, Stephen Machin, Ludger Wößmann. Amsterdam: North Holland: 89-200.

Hout, Michael, Stuart W. Elliott, eds. 2011. Incentives and test-based accountability in education. Washington, DC: National Academies Press.

Koretz, Daniel. 2017. The testing charade: Pretending to make schools better. Chicago: University of Chicago Press.

Ramirez, Francisco O., Evan Schofer, John W. Meyer. 2018. "International tests, national assessments, and educational development (1970-2012)." Comparative Education Review 62, no. 3: 344-364.

Wößmann, Ludger. 2016. "The importance of school systems: Evidence from international differences in student achievement." Journal of Economic Perspectives 30, no. 3: 3-32.

Wößmann, Ludger. 2018. "Central exit exams improve student outcomes." IZA World of Labor 2018: 419.

World Bank. 2018. World Development Report 2018: Learning to realize education's promise. Washington, DC: World Bank.

©KOF ETH Zürich, 25. Sep. 2018